Aż trudno uwierzyć, że dzisiaj mija równe ćwierć wieku od momentu jak NVIDIA zrewolucjonizowała rynek komputerów. Dało to podwaliny pod obecny sukces firmy, to jak wyglądają gry wideo oraz jak szybko rozwija się sztuczna inteligencja.

W 1999 roku na językach wszystkich był dopiero co wypuszczony w kinach film Matrix, a szczytową popularnością cieszyła się Britney Spears i Eminem. Część osób obawiała się też końca świata mającego nadejść wraz z 2000 rokiem. Jednak w tym samym czasie działo się coś znacznie bardziej przełomowego.

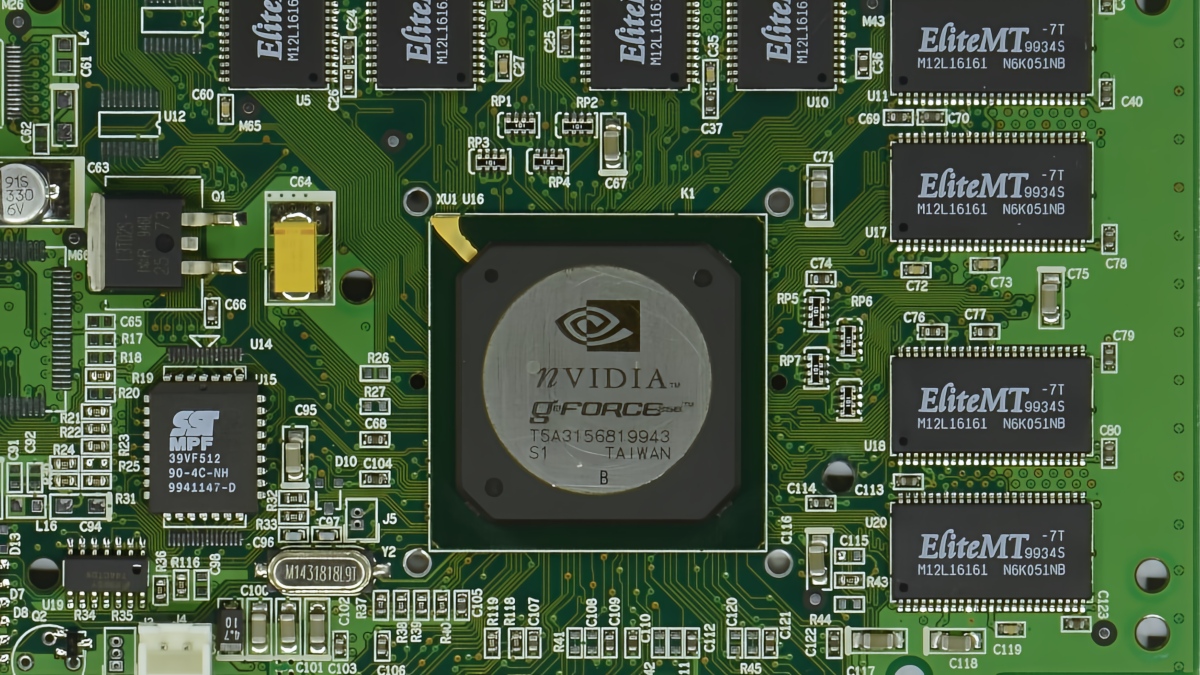

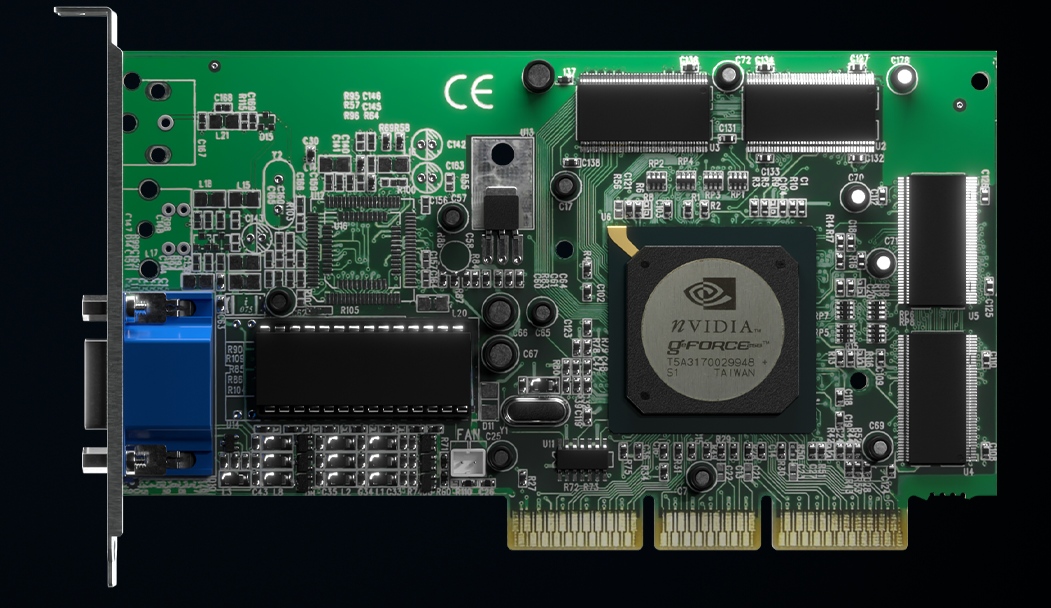

Premiera karty graficznej NVIDIA GeForce 256, która miała miejsce 25 lat temu, początkowo przeszła niemal bez echa. Wyjątkiem byli zapaleni entuzjaści komputerowi. To jednak właśnie ta karta, uznana za pierwszą na świecie jednostkę GPU, położyła fundamenty pod dzisiejszy rozwój sztucznej inteligencji.

Propozycja Zielonych wprowadziła szereg nowych rozwiązań, takich jak T&L, które pozwalały na odciążenie CPU. To zaś pozwalało twórcom gier na zaoferowanie lepszej, bardziej skomplikowanej oprawy graficznej w grach. Dało się wtedy usłyszeć, że ulubione tytułu z GeForce 256 wyglądają zupełnie inaczej.

W połączeniu z rewolucyjnymi tytułami, takimi jak Unreal Tournament - jedną z pierwszych gier oferujących realistyczne odbicia, która sprzedała się w ponad milionie egzemplarzy tylko w pierwszym roku dostępności - GeForce 256 wyznaczył nowy standard w grafice komputerowej.

W ciągu kolejnych 25 lat współpraca między NVIDIĄ, a twórcami gier przyniosła kolejne innowacje, takie jak coraz bardziej realistyczne tekstury, dynamiczne oświetlenie oraz płynniejszy obraz. To, co zaczęło się od gier, z czasem stało się platformą technologicznych innowacji.

W miarę jak gry stawały się bardziej złożone, rosły również wymagania sprzętowe. Architektura GPU, która zrewolucjonizowała grafikę, przyciągnęła uwagę naukowców zajmujących się sztuczną inteligencją. Zorientowali się oni, że GPU może także obsługiwać zaawansowane obliczenia potrzebne do trenowania modeli.

W 2011 roku badacze z Google, Stanford i New York University zaczęli wykorzystywać karty NVIDIA do przyspieszania rozwoju sztucznej inteligencji. Osiągali przy tym wyniki, które wcześniej były możliwe tylko dzięki superkomputerom. Przełom nastąpił w 2012 roku, kiedy Alex Krizhevsky z Uniwersytetu Toronto wygrał konkurs rozpoznawania obrazów ImageNet, deklasując konkurencję.

Od tamtego momentu sztuczna inteligencja zaczęła osiągać poziom wykraczający poza możliwości człowieka. Google, Microsoft i Baidu przewyższyły ludzkie zdolności w zadaniach takich jak rozpoznawanie obrazów i przetwarzanie mowy, wszystko dzięki mocy obliczeniowej kart graficznych.

W 2016 roku Jensen Huang, założyciel oraz prezes NVIDII, przekazał pierwszy superkomputer AI - NVIDIA DGX-1 - organizacji OpenAI, która wykorzystała jego moc do trenowania najlepszym obecnie na rynku modeli sztucznej inteligencji, w tym ChatGPT, uruchomionego w 2022 roku.

Oczywiście z tego rozwoju korzystają też gracze. W 2018 roku Amerykanie zaprezentowali serię GeForce RTX 2000 z rdzeniami RT oraz jednostkami Tensor, przeznaczonymi do obsługi zaawansowanych zadań takich jak śledzenie promieni w czasie rzeczywistym i obliczenia AI. To zaś dało podwaliny pod takie technologie jak NVIDIA DLSS, które dzięki uczeniu maszynowemu podnosi dzisiaj wydajność w grach.

Tym samym śmiało można powiedzieć, że układ NVIDIA GeForce 256 położył podwaliny pod przyszłość, w której gry, komputery i AI nie tylko ewoluują - one wspólnie przekształcają otaczający nas świat.

Zobacz: NZXT przygotowało wyjątkowo estetyczne płyty główne

Zobacz: TeamGroup przesuwa granice. Nadciągają rekordowo szybkie pamięci RAM

Źródło zdjęć: NVIDIA

Źródło tekstu: NVIDIA, oprac. własne